Der Energieverbrauch von Rechenzentren weltweit nimmt immer weiter zu. Ein Grossteil der aufgewendeten Energie wird für ineffiziente Luftkühlung verschwendet. Innovative Kühlsysteme basierend auf einer dielektrischen Hightech-Flüssigkeit bieten eine Lösung. Pionierprojekte in Hongkong und Leeds (UK) zeigen, dass damit bei der Kühlung bis zu 97 Prozent Energie eingespart werden kann.

Von Markus Meier, Marketing Coordinator, 3M Electronics, Alpine Region

Der Energiebedarf von Rechenzentren weltweit ist enorm: Sie verursachen rund 2 Prozent des weltweiten CO2-Ausstosses – und damit etwa gleich viel wie der gesamte Luftverkehr. Der Bedarf an Rechenleistung wird in den kommenden Jahren weiter stark zunehmen, unter anderem durch den vermehrten Einsatz von Cloud Computing. Die Steigerung der Energieeffizienz von Rechenzentren ist deshalb eine zentrale Herausforderung. Ein grosses Potenzial liegt bei der Kühlung. In vielen Rechenzentren verschlingt diese 30 bis 40 Prozent des Gesamtenergieverbrauchs.

Teure Kühlung

Die traditionelle Luftkühlung der Serverracks ist sehr ineffizient und teuer. Sie besteht aus mehreren Stufen, bei denen Ventilatoren die heisse Luft von den Prozessoren wegbläst und kühlere Luft nachströmt. Die Energieverschwendung dabei ist immens – nicht nur ist Luft ein sehr schlechter Wärmeträger, die verschiedenen Ventilatoren, Pumpen und Kompressoren, die in diesem System verwendet werden, beziehen einiges an Leistung. Obwohl in den letzten Jahren deutliche Verbesserungen erzielt werden konnten, bleibt es die ineffizienteste Kühlmethode – und hat den zusätzlichen Nachteil, dass die Elektronik nicht sehr dicht aufgebaut werden kann, damit die Luft zirkulieren kann.

Neuere Ansätze wie Wasserkühlung sind zwar effizienter und erlauben auch höhere Dichten, bringen aber wieder andere Nachteile mit sich: So darf das Kühlsystem bei der Verwendung von Wasser auf keinen Fall lecken, sonst drohen Kurzschlüsse und somit kostspielige Ausfälle.

Elektronik eintauchen

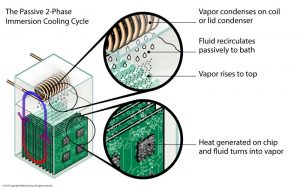

(Bild: 3M)

Ein innovativer Ansatz ist das Immersion Cooling, bei dem die Elektronik direkt in eine dielektrische Flüssigkeit eingetaucht wird. Um die Elektronik nicht zu beschädigen, darf das Medium weder korrodierend noch elektrisch leitend sein. Die thermische Leitfähigkeit hingegen soll so hoch wie möglich sein. Die neuartige Hightech-Flüssigkeit Novec von 3M erfüllt diese Anforderungen.

Zweiphasen-Immersion-Cooling wird schon seit längerer Zeit verwendet, um beispielsweise Supercomputer zu kühlen. Es ermöglicht hohe Dichten und eine hohe Performance. Der Nachteil ist, dass das System gegen aussen hermetisch verschlossen sein muss – was Anschlüsse teuer und den Servicezugang zu einer hochkomplexen Angelegenheit macht. Das neue 3M-Konzept Open Bath Immersion Cooling (OBI) löst diese Probleme auf elegante Weise: Es verwendet halboffene Bäder statt hermetischen Verschalungen.

Die Server werden dafür nebeneinander in einem zugedeckten Bad aus dielektrischer Flüssigkeit platziert. Die Abwärme der Elektronik bringt die Flüssigkeit aufgrund derer tiefen Siedetemperatur zum Verdampfen. Der dabei entstehende Dampf kondensiert an einem wassergekühlten Kondensator und wird dem System wieder zugeführt. Der Clue dabei: Das Abführen des Dampfs benötigt keinerlei Energie – er steigt auf und tropft nach der Kondensation zurück ins Bad. Durch die halboffene Konstruktion sind Servicezugriffe einfach und ungefährlich: Novec ist nicht giftig.

Energieeffizientestes Datencenter Asiens

Verschiedene Unternehmen arbeiten mit 3M zusammen, um auf Novec basierende Immersionskühlungssysteme zu entwickeln. Allied Control aus Hongkong hat sich auf High-Densitiy-Kühlsysteme spezialisiert, die das OBI-Prinzip nutzen. Ein Vorzeigeprojekt ist Immersion-1, der grösste FPGA-Cluster der Welt: 6048 FPGA-Chips, die insgesamt 890 Mio. Logikzellen aufweisen. Das Rechenzentrum einer Finanzfirma führt SHA-256-Hashing-Algorithmen für digitale Unterschriften bei Finanztransaktionen durch. Zunächst wollte das Unternehmen dafür Xeon-Server mit Luftkühlung verwenden – dies hätte laut Schätzungen von Allied Control 200 Serverracks und ungefähr 6,4 Megawatt an Kühlleistung benötigt. Die Verwendung eines Flüssigkühlsystems erlaubt hingegen den Einsatz von FPGAs anstelle der Server. Bei Luftkühlung wären die Chips innerhalb von Sekunden überhitzt, da die Algorithmen ihnen höchste Leistungen abverlangen. Das System ist aber nicht nur um Faktoren kleiner, die Anlage verbraucht dazu rund 90 Prozent weniger Energie für die Kühlung. So werden jährlich 45 000 Tonnen CO2 eingespart.

(Bild: Allied Control)

Das zweite Projekt, Immersion-2, ging im Herbst 2013 in Betrieb: Ein 500-Kilowatt-Rechenzentrum, ebenfalls gekühlt durch Open Bath Immersion Cooling. Das System ist modular aufgebaut und verwendet normale 19-Inch-Racks. Es konnte innerhalb von sechs Monaten vollendet werden und ist das energieeffizienteste Datencenter ganz Asiens.

Dass die beiden Rechenzentren in Hongkong stehen, ist kein Zufall. Sowohl die Immobilien- als auch die Elektrizitätspreise sind an diesem Standort sehr hoch; platz- und energiesparende Systeme sind enorm wichtig. Umso erstaunlicher ist, dass die Systeme im feuchtheissen Klima eine Power Usage Effectiveness (PUE) von 1.02 aufweisen – das bedeutet, dass sie zu den effizientesten Systemen der Welt gehören. Im Vergleich zu luftgekühlten Systemen verbrauchen sie 95 Prozent weniger an Energie. Die Firma spart so jeden Monat 64 000 US-Dollar an Stromkosten allein für die 500-Kilowatt-Anlage.

Auszeichnung für Green IT

Ein anderes Prinzip verwendet das britische Start-Up Iceotope, das seit 2009 an einem neuen Flüssigkühlmodul arbeitet. Hier bleibt Novec immer in seinem flüssigen Zustand und wird verwendet, um die Hitze von der Elektronik an ein Wasser-Kühlsystem abzugeben. Dazu wird jedes Server-Motherboard vollständig in Novec eingetaucht. Die Flüssigkeit transferiert die Hitze passiv an einen Wärmetauscher, in dem Wasser zirkuliert, angetrieben durch eine Low-Power-Pumpe. Dieses System ist fast geräuschlos und macht eine energieintensive Raumklimatisierungsanlage überflüssig. Ausserdem kann die Wassertemperatur des Kühlwassers im Input bis zu 45 °C betragen – es muss also nicht zusätzlich gekühlt werden. Das System benötigt gerade mal 80 Watt, um die Hitze abzuführen, die das IT-Equipment von bis zu 20 Kilowatt Leistung erzeugt. Das von Iceotope entwickelte Servermodul verwendet kommerzielle Standard-Motherboards und lässt sich mit Komponenten verschiedener Hersteller ausrüsten. Damit kann gemäss Iceotope bei der IT bis zu 20 Prozent an Energie eingespart werden, bei der Raumkühlung gar bis zu 97 Prozent.

Ein solches System wurde in einem ersten Projekt an der Universität Leeds installiert. Deren High Performance Computing (HPC)-System, das für Simulationen und andere anspruchsvolle Berechnungen in der Forschung verwendet wird, wurde durch das flüssiggekühlte Serversystem von Iceotope ersetzt. Die Absicht der Universität war es, den CO2-Fussabdruck ihrer Rechensysteme zu reduzieren – und das ist ihnen auch gelungen: Der Energieaufwand für die Kühlung konnte um über 80 Prozent gesenkt werden.

Ein weiteres Ziel des Projekts war, zu prüfen, ob die Abwärme von IT-Systemen genutzt werden kann. Auch dieses wurde erfüllt: Ein sekundärer Warmwasserkreislauf nimmt die Wärme aus dem Serverschrank auf und verwendet sie, um das Labor für Thermofluidmechanik zu heizen.

Das Projekt begeisterte unter anderem das Uptime Institute in New York, das der Universität Leeds, Iceotope und 3M Ende 2013 den Green Enterprise IT Award verlieh. Diese Auszeichnung wird jährlich an Projekte und Innovationen verliehen, die den Energie- und Ressourcenverbrauch von IT signifikant verbessern.

Power Usage Effectiveness (PUE)

Die Power Usage Effectiveness, kurz PUE, bezeichnet einen international anerkannten Messwert für die Energieeffizienz von Rechenzentren. Er berechnet sich puttygen , indem der gesamte Energieverbrauch eines Rechenzentrums durch die Energie, die vom IT-Equipment verbraucht wird, geteilt wird.

PUE = (Gesamter Energieverbrauch) / (Energieverbrauch durch IT)

Je näher dieser Wert an 1.0 liegt, desto effizienter ist das Rechenzentrum. Ein PUE von 1.0 würde also ein Rechenzentrum bedeuten, bei dem keinerlei Energie durch Infrastruktur wie beispielsweise Kühlung oder Beleuchtung verbraucht wird.

Nützliche Links: www.3m.com